通过硅基流动来搭建自己的AI模型

使用云端大模型

使用云端大模型部署是最为便捷的方式,对本地的电脑性能没要求。

硅基流动账户配置

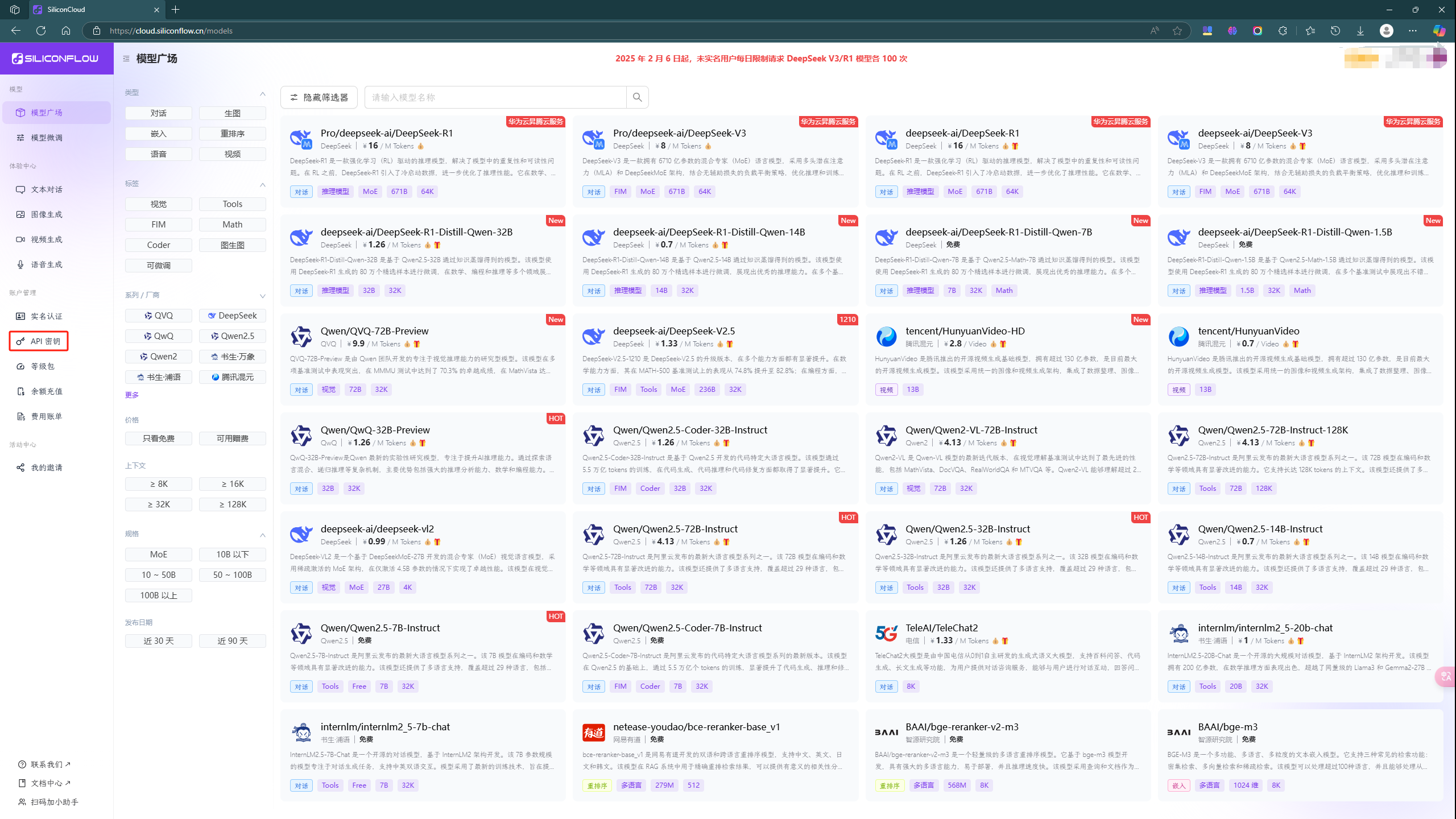

硅基流动是提供大模型的厂商,我们能通过它提供的云端大模型选择满足自己需求的大模型。

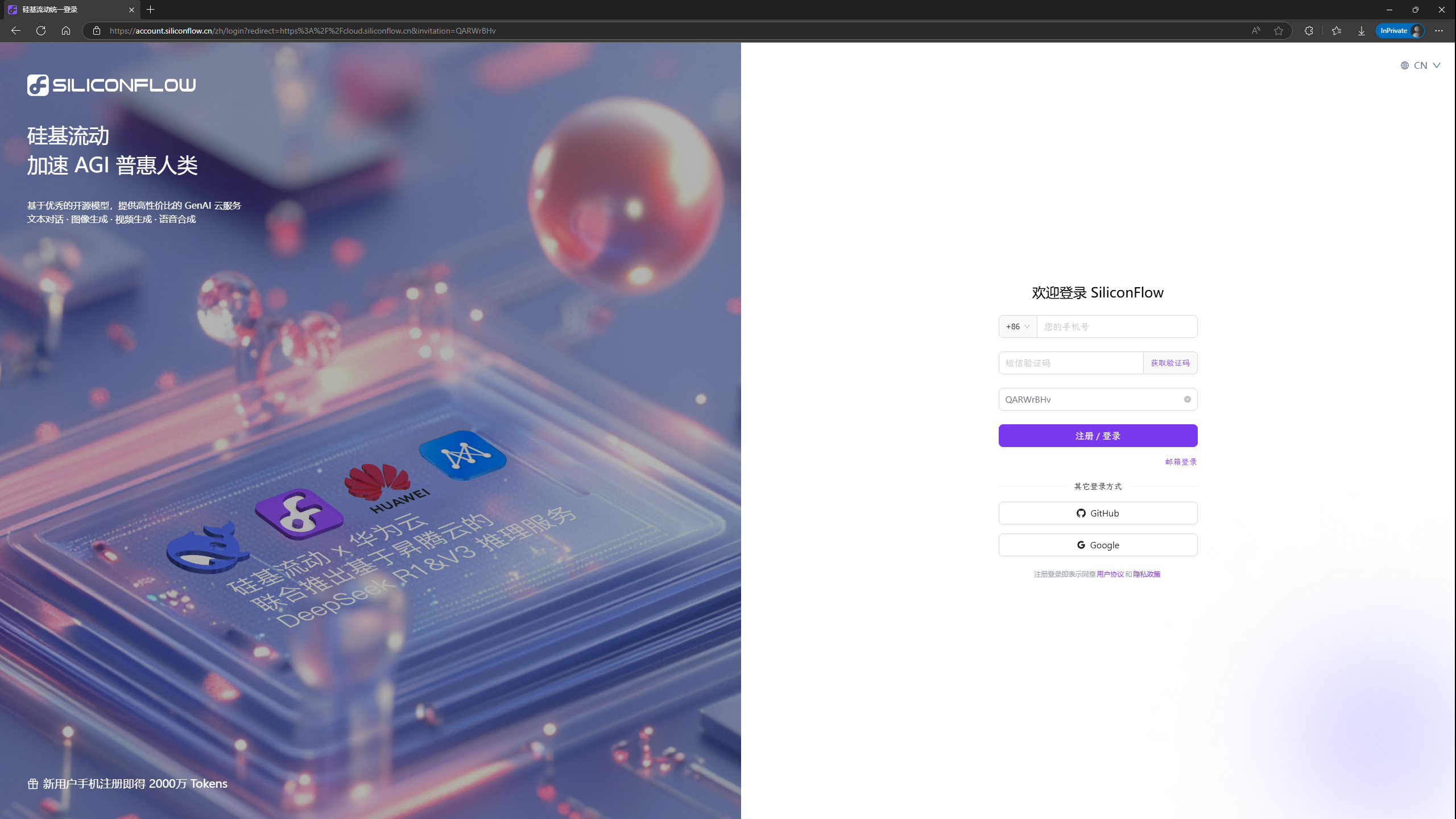

账号注册

可以通过此链接进行账号注册。

可以直接输入手机号进行注册或登录。

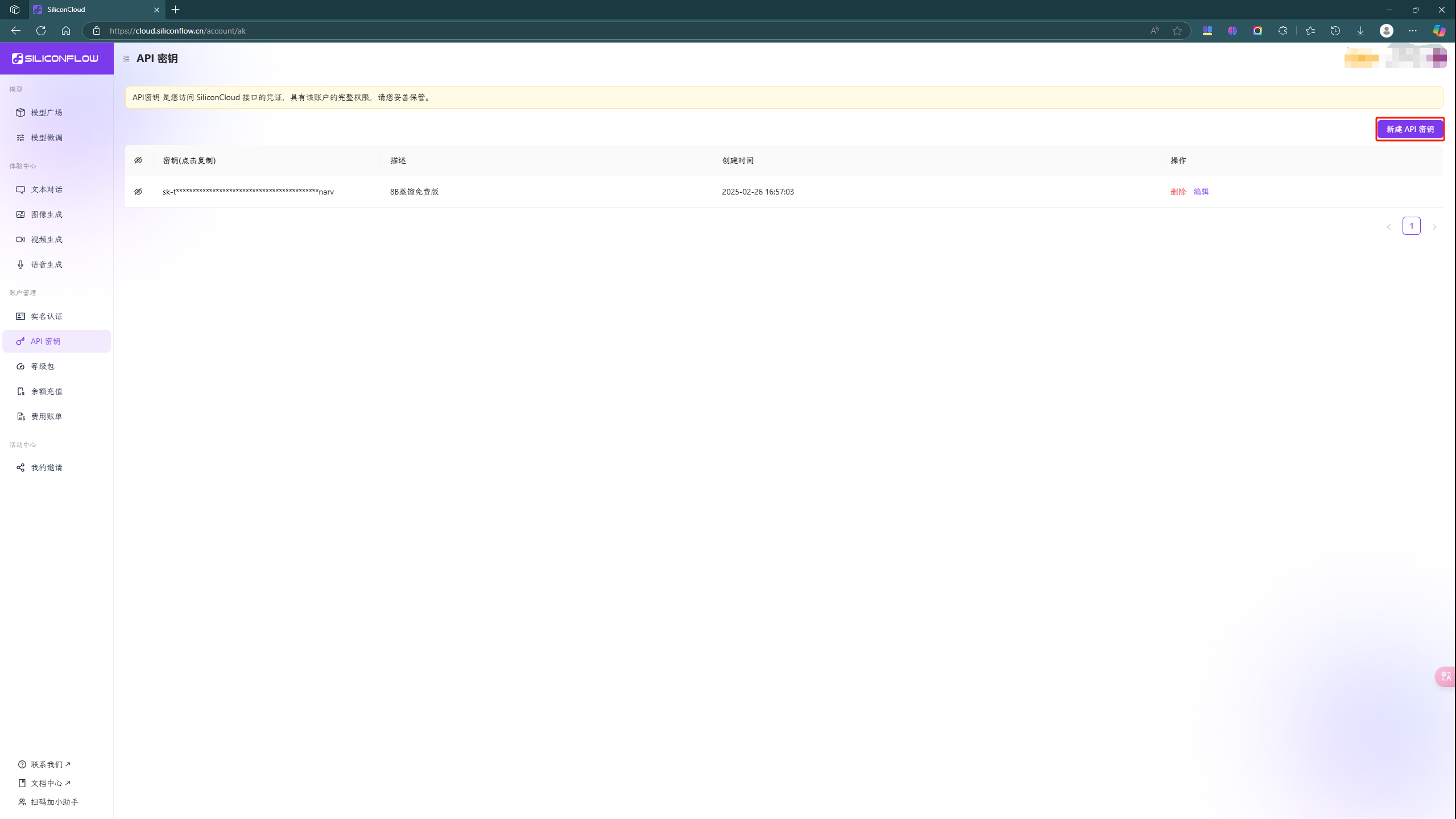

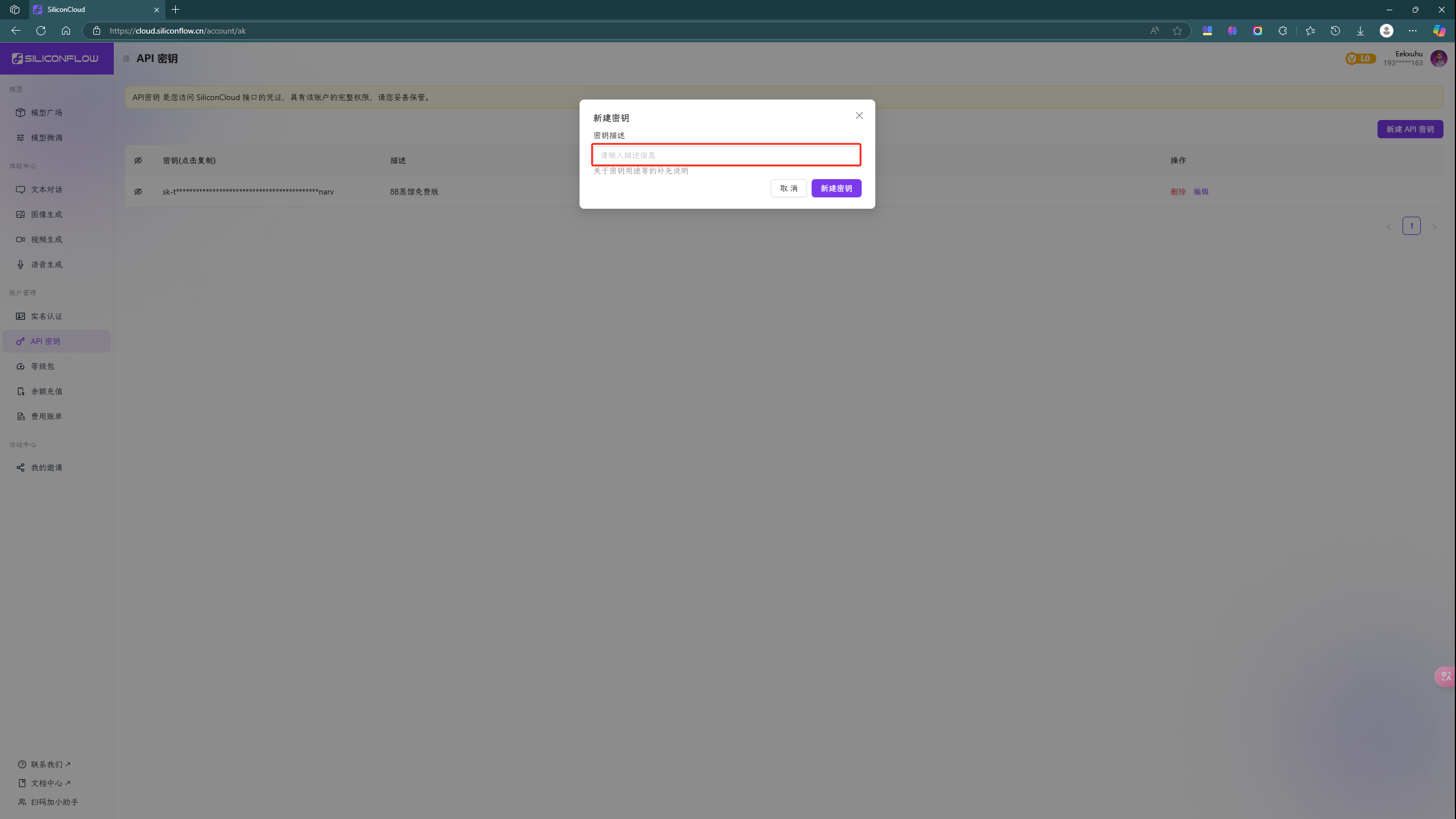

API 密钥生成

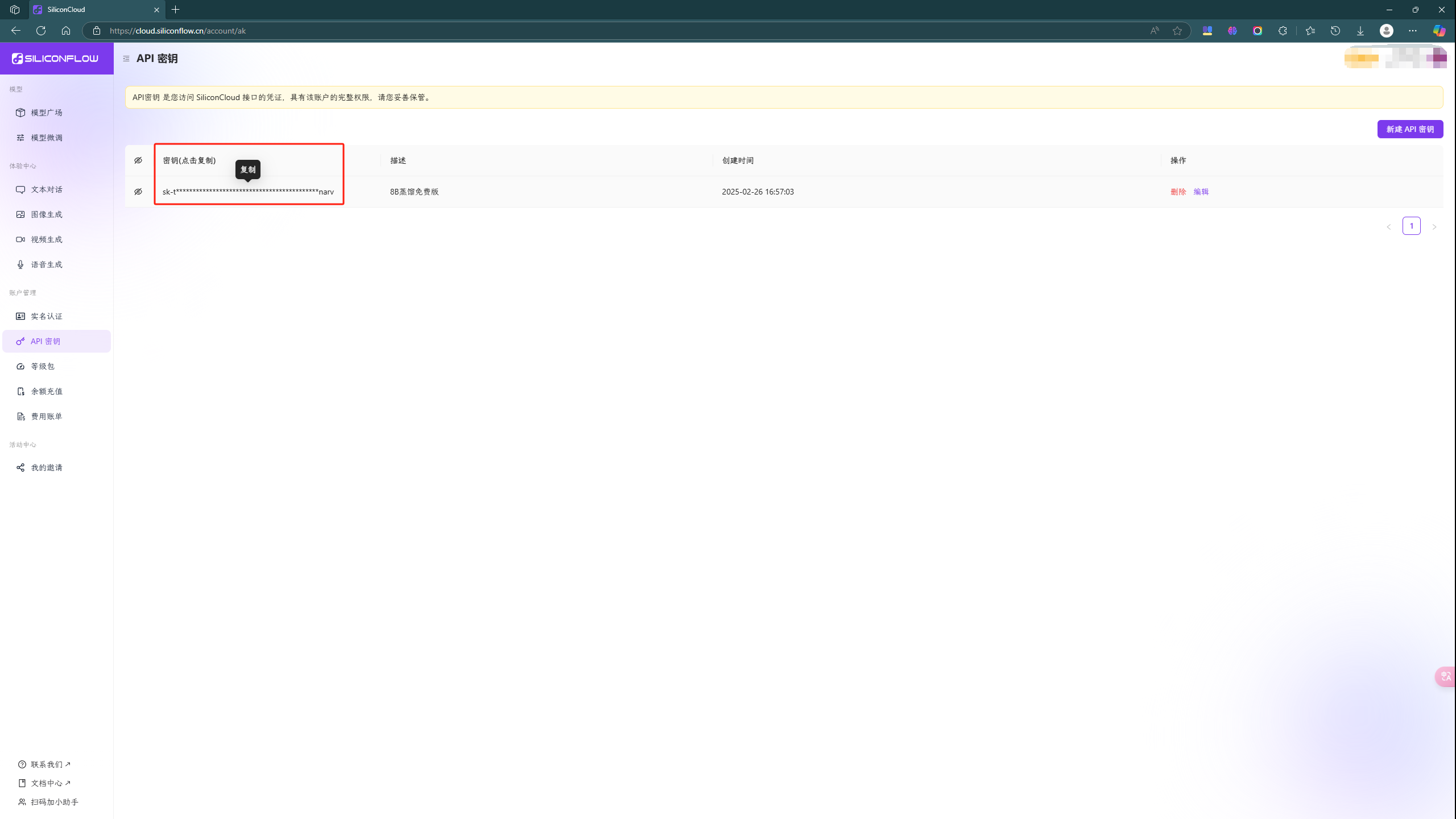

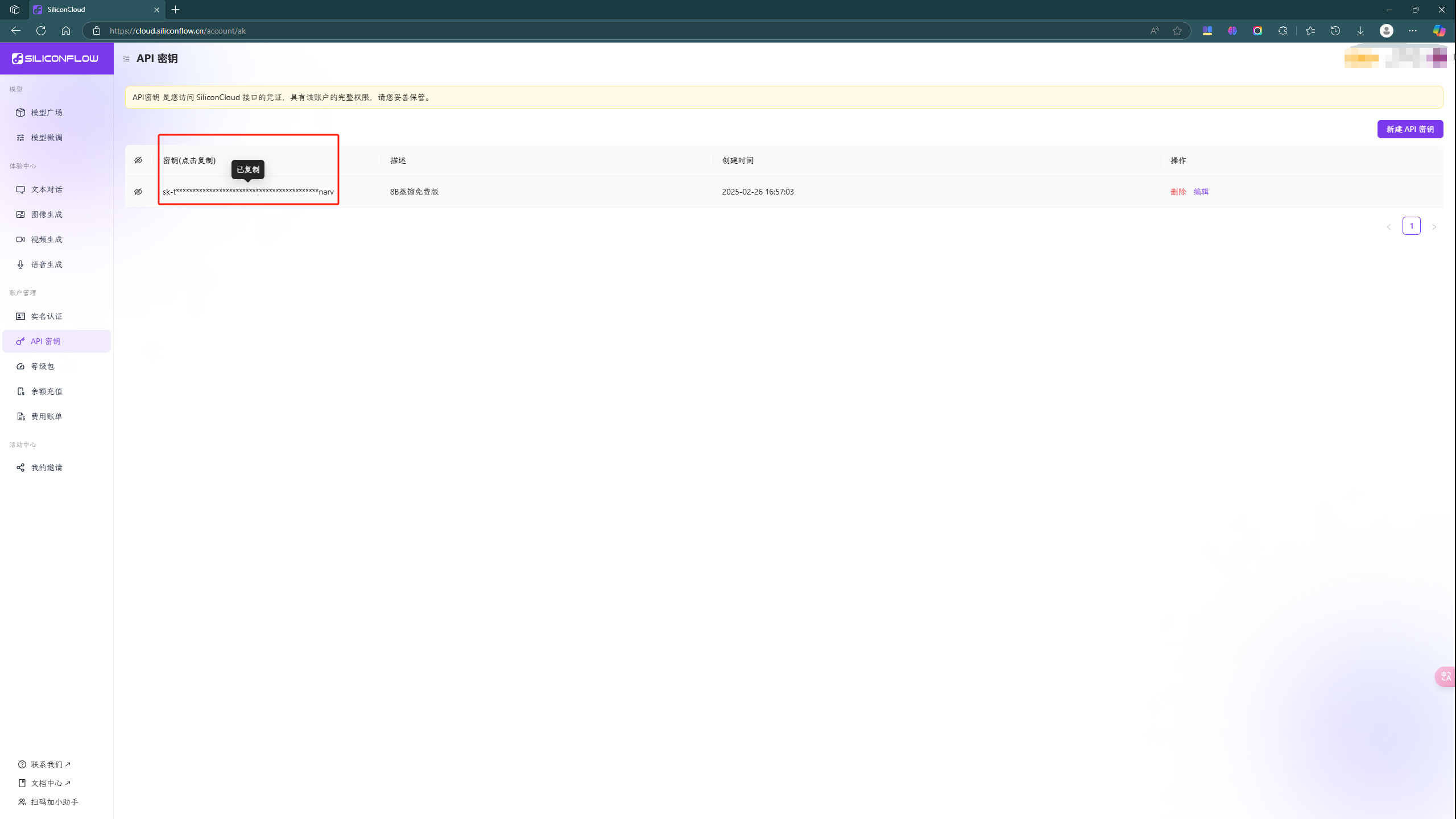

登录后在左侧侧边栏选择 API 密钥 选项。

在 API 密钥页面在右上角选择 新建 API 密钥 。

之后在弹出的对话框里输入待生成密钥的备注,然后点击 新建密钥 按钮即可。最后就会生成如上图所示的密钥了(刚注册的账户是没有密钥的)。

用户端软件配置

当配置好大模型API接口后,可以根据自己的需求选择一个平台设置好用户端的配置。

Windows 平台

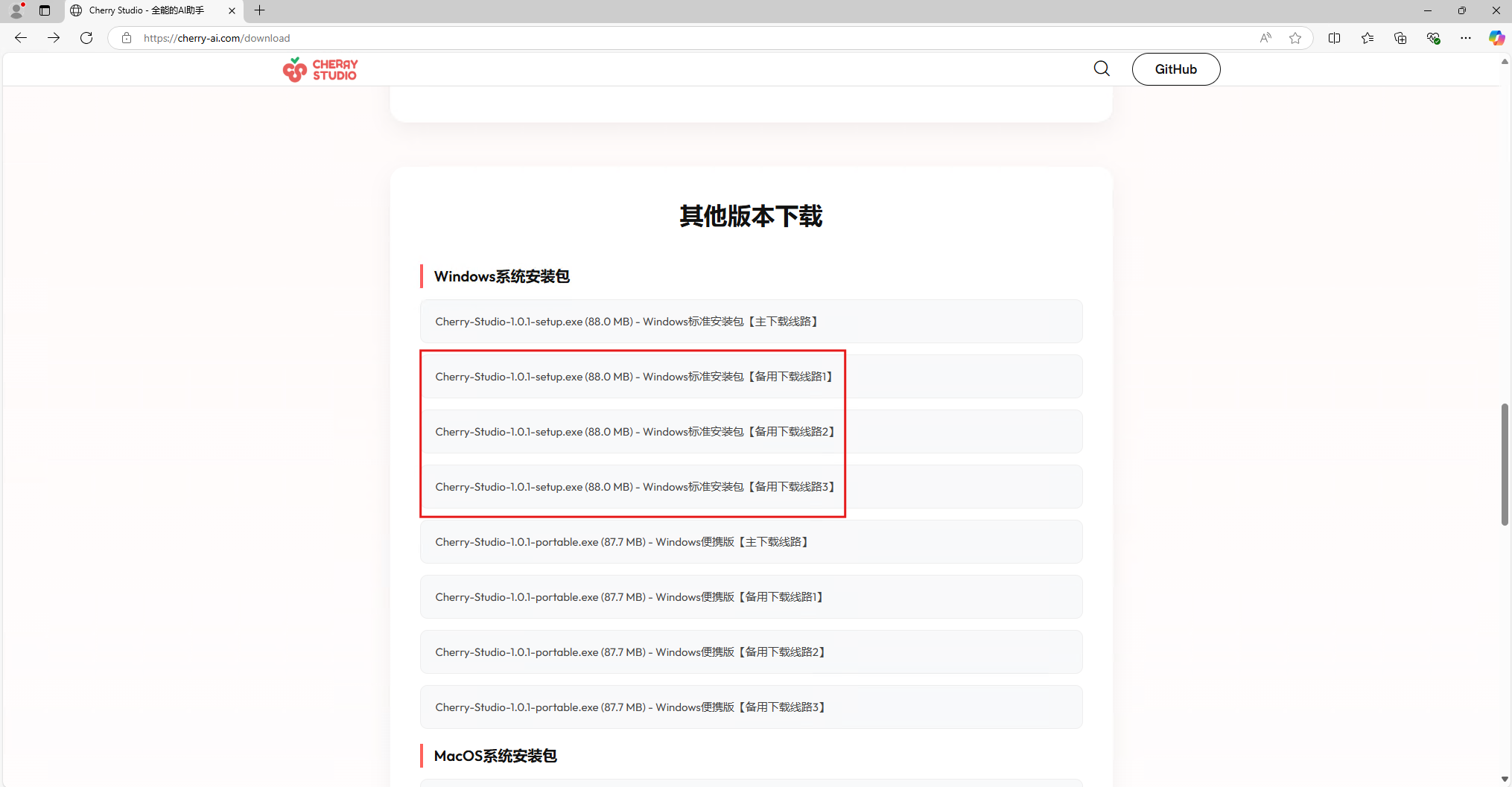

Cherry Studio 安装

安装 Cherry Studio 客户端。如果点击 立即下载 后下载速度很慢或者无法下载,请点击 其他版本或备用路线下载 ,之后任选一个链接来下载。

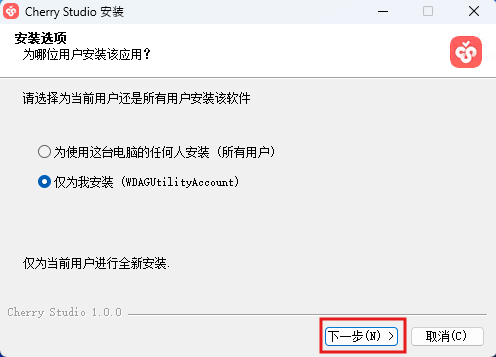

双击安装软件,弹出安装界面后,直接点击下一步

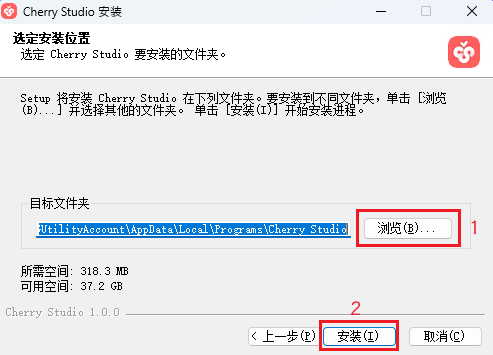

第二个安装页面是选择安装路径(默认是安装在 C 盘里),如果需要更改点击(1)即可,选择完毕后点击(2)进行安装。

添加 AI 模型

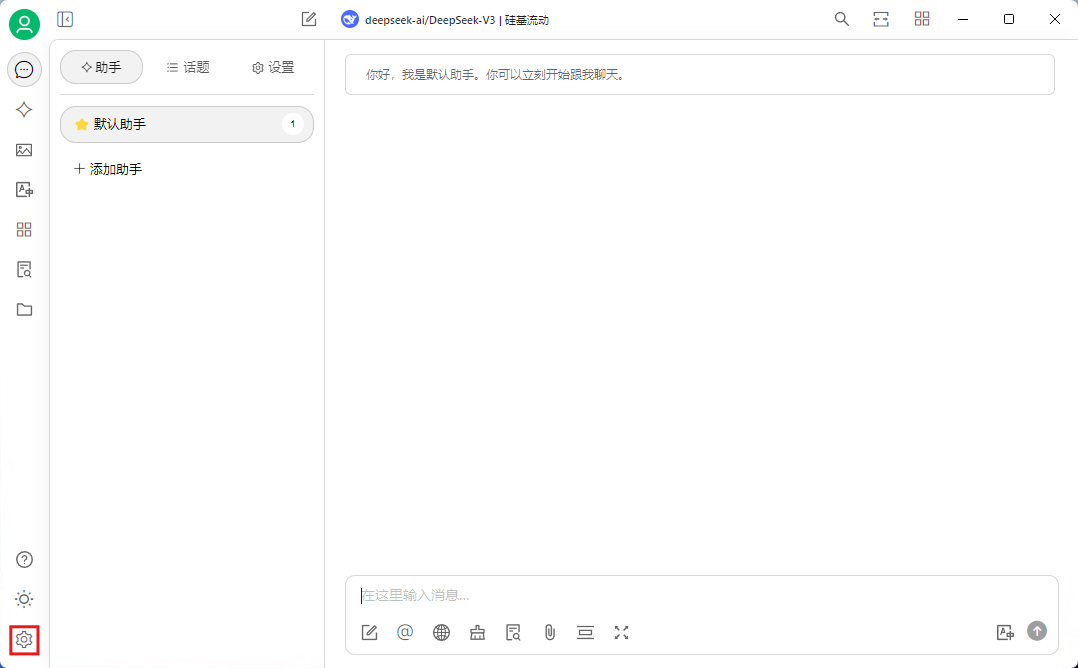

安装完成后打开 Cherry Studio 客户端。之后点击侧边栏左下角的设置选项。

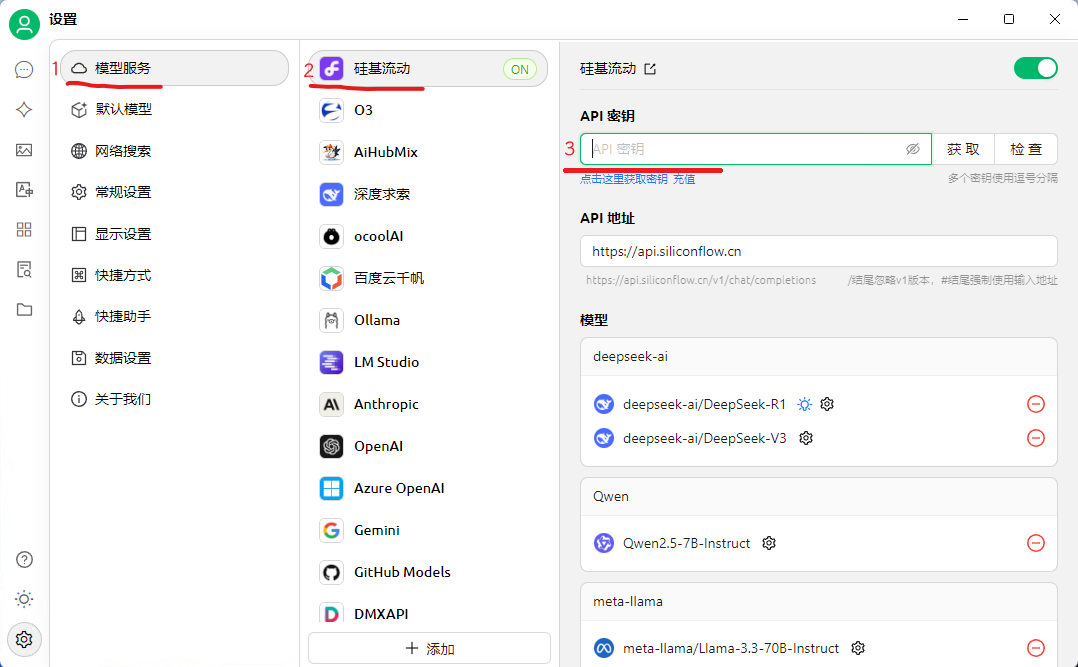

进入设置页面后,请确认菜单栏 1、2 是按如下选择的。之后在 3 处粘贴之前生成的密钥(复制密钥流程见下图)。

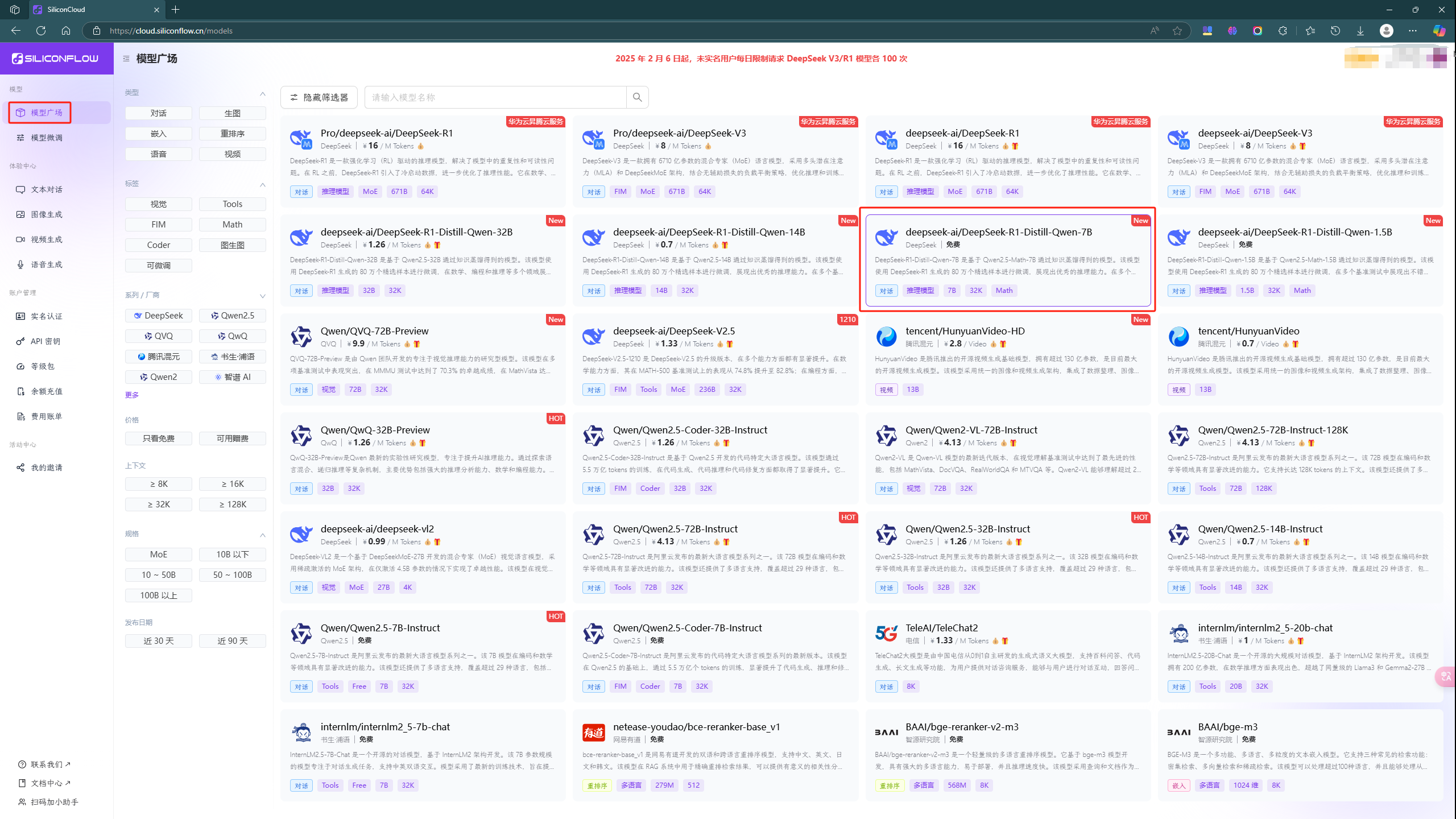

之后点在 模型广场 页面选择并点击 deepseek-ai/DeepSeek-R1-Distill-Qwen-7B 模型。

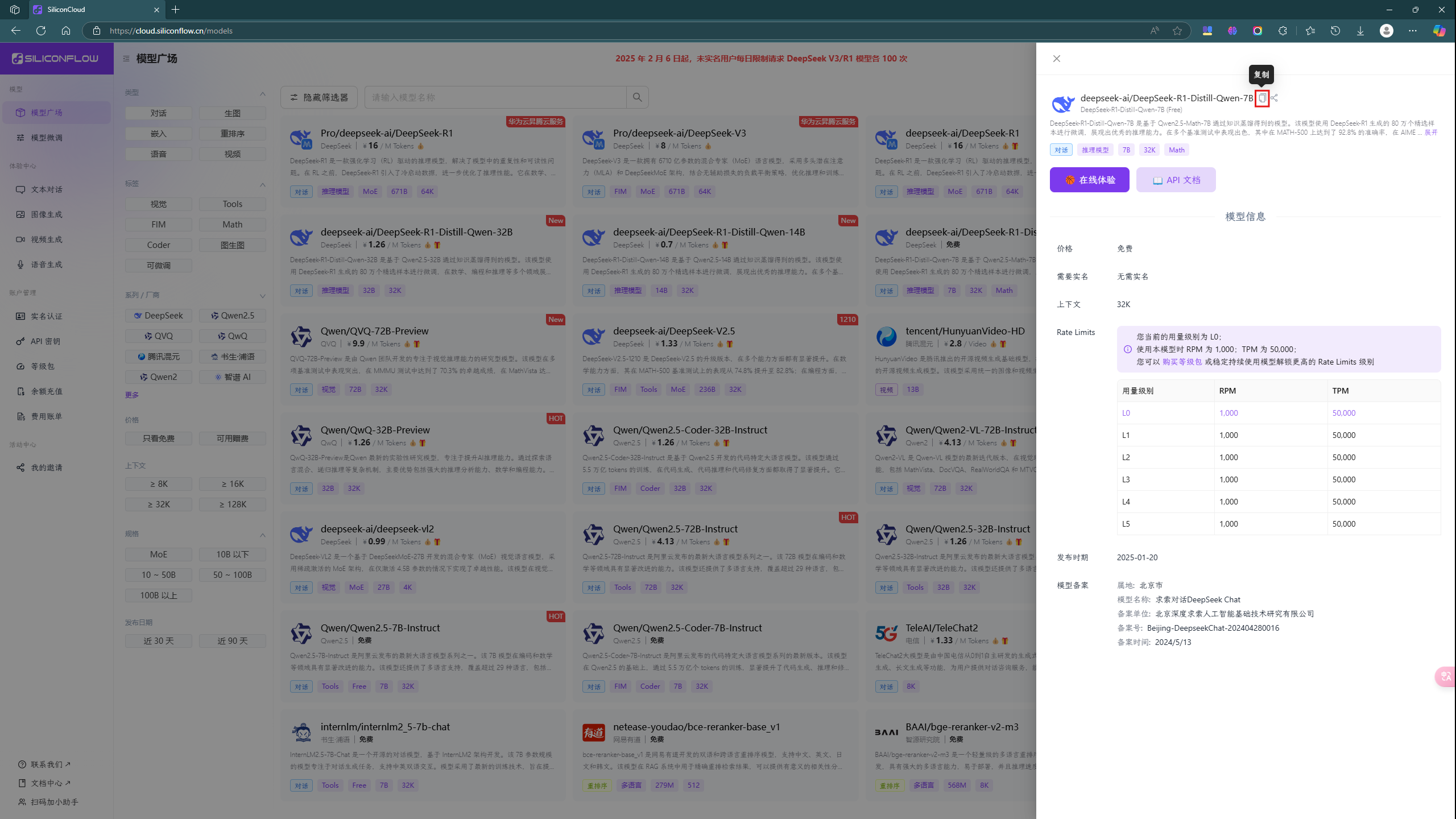

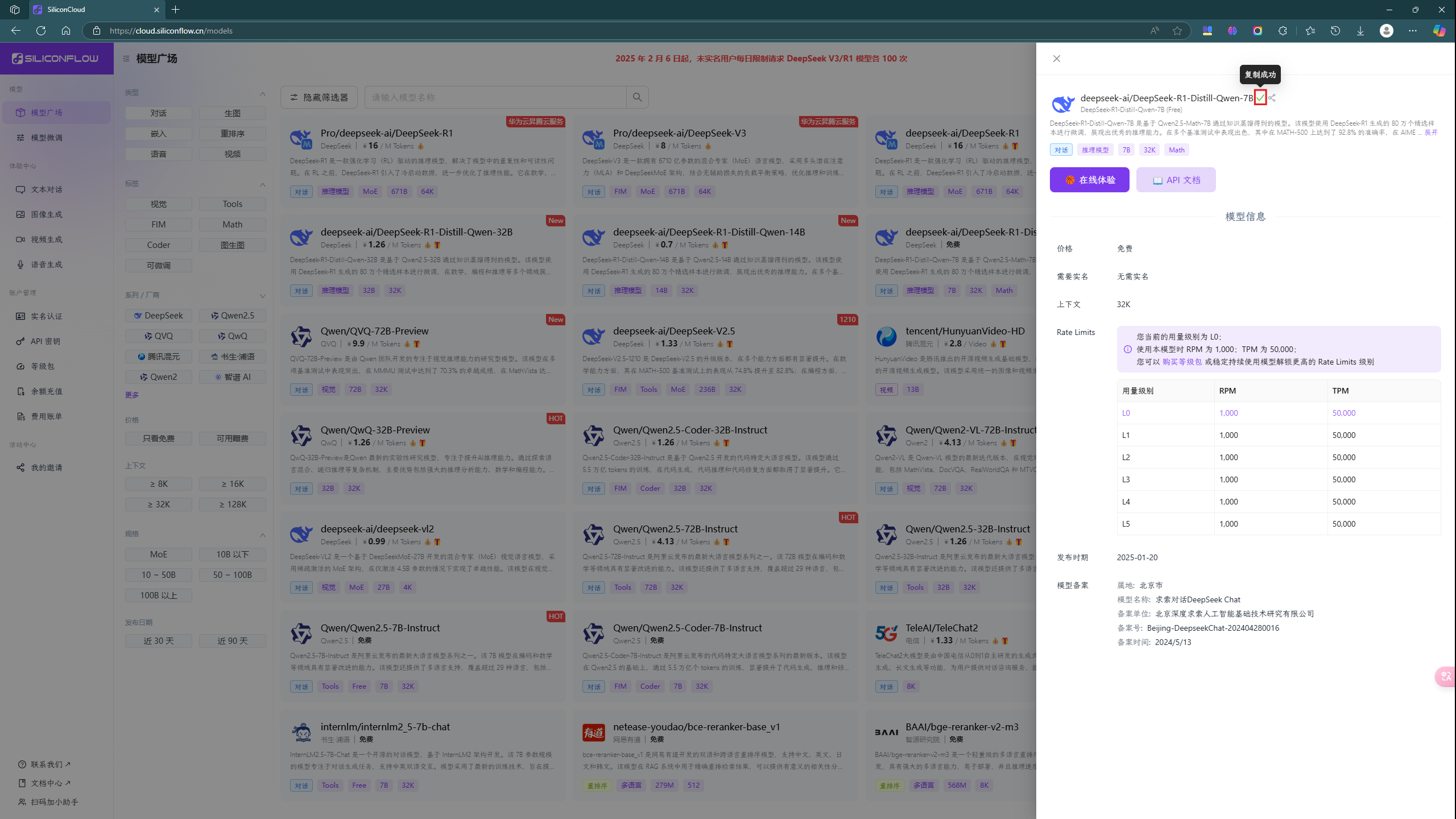

然后点击复制按钮复制模型名称。

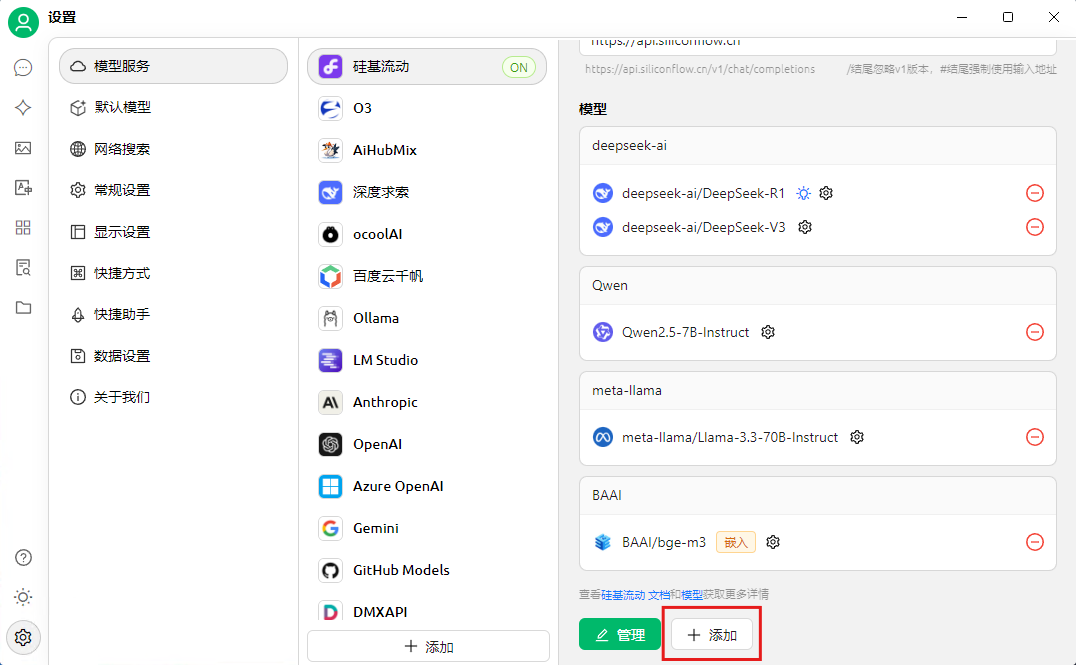

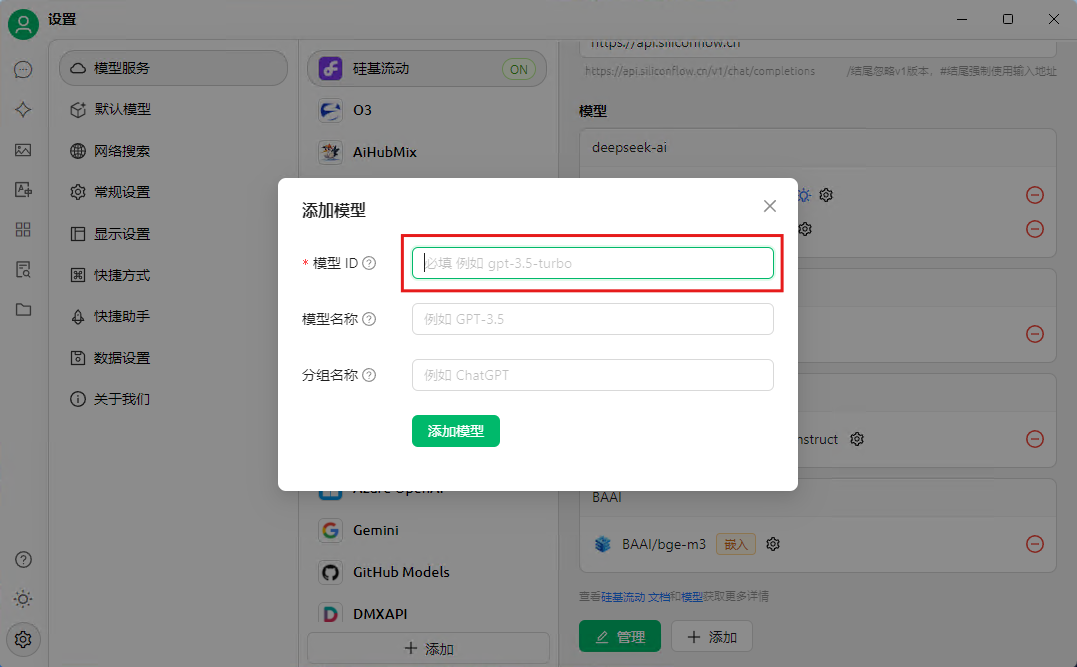

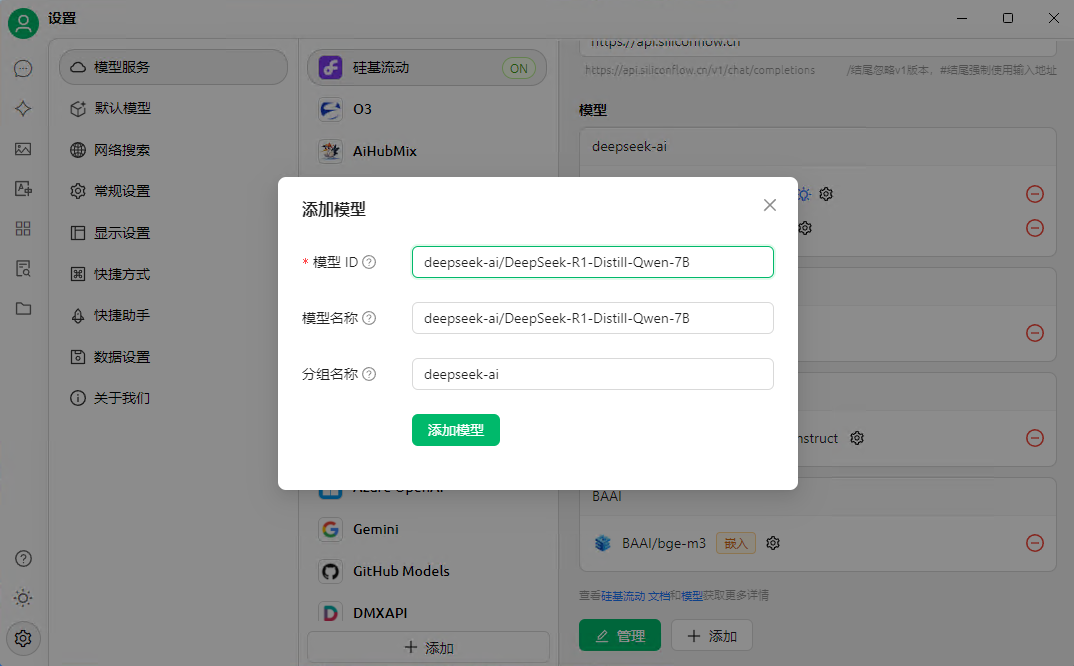

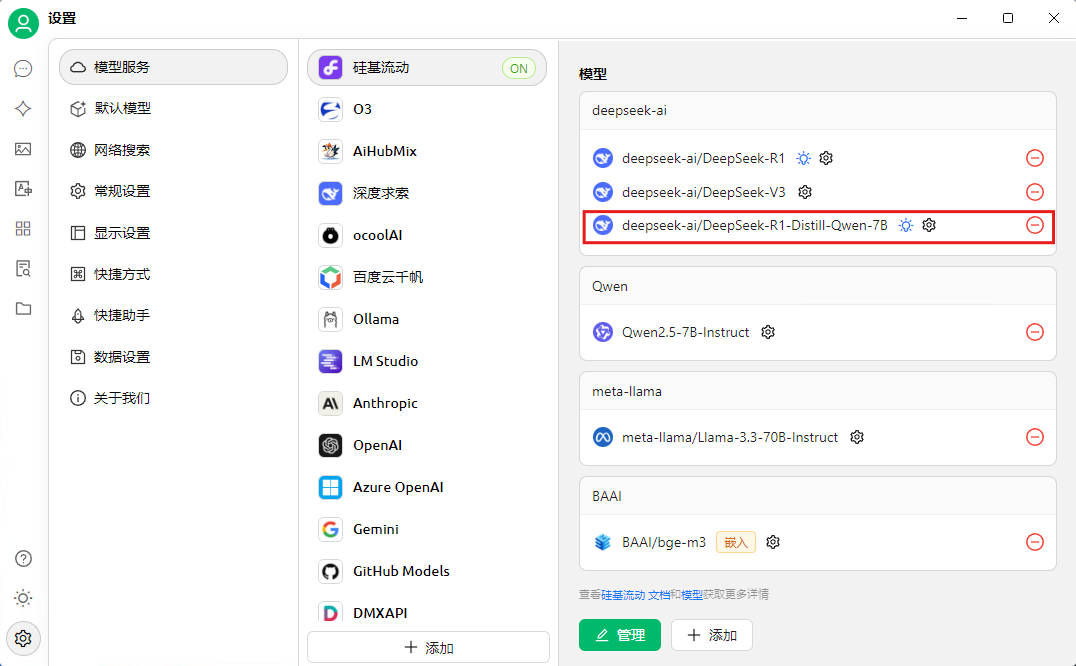

之后在 Cherry Studio 里的设置页面的右边第三个内容框里往下滑动到底,点击 添加 按钮,把刚才复制的模型名称填写到第一个框中(剩余框会自动填充),最后点击 添加模型 按钮。

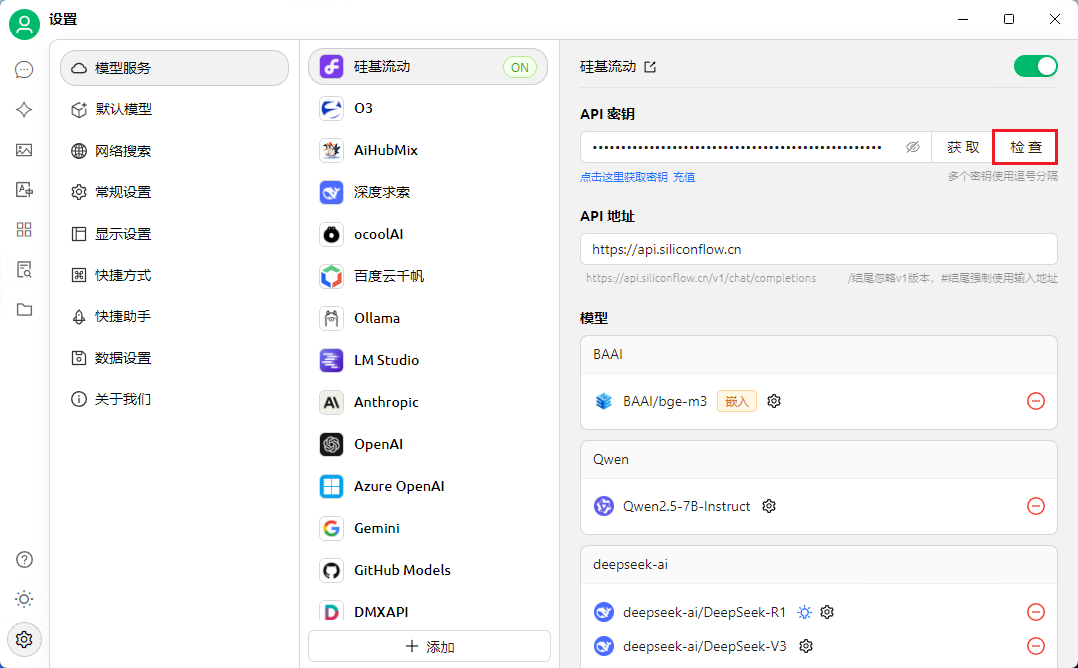

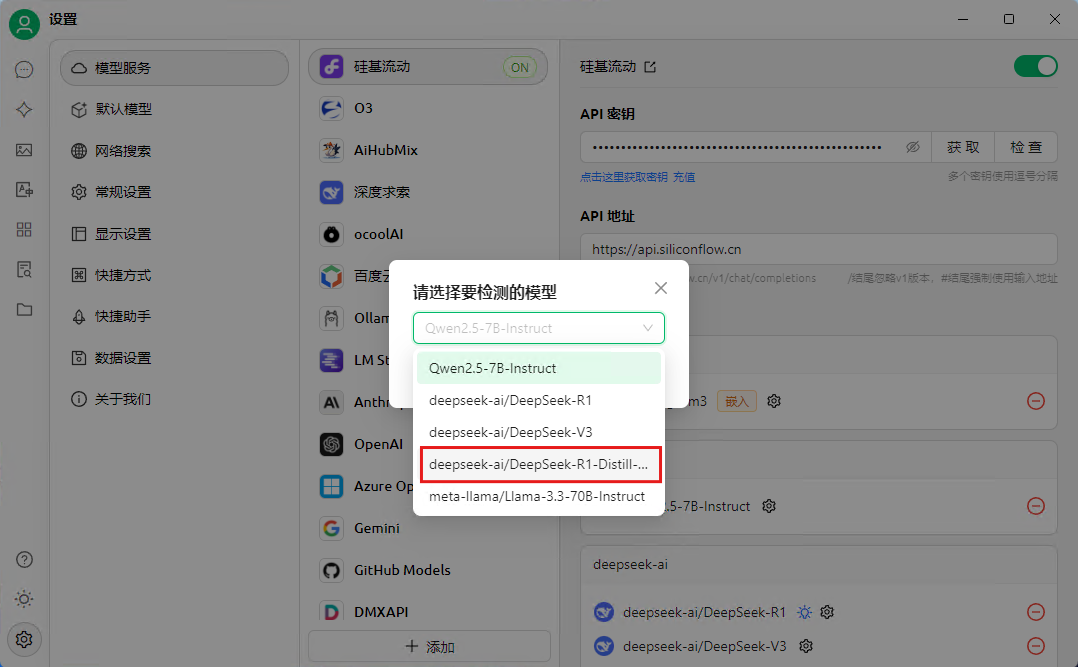

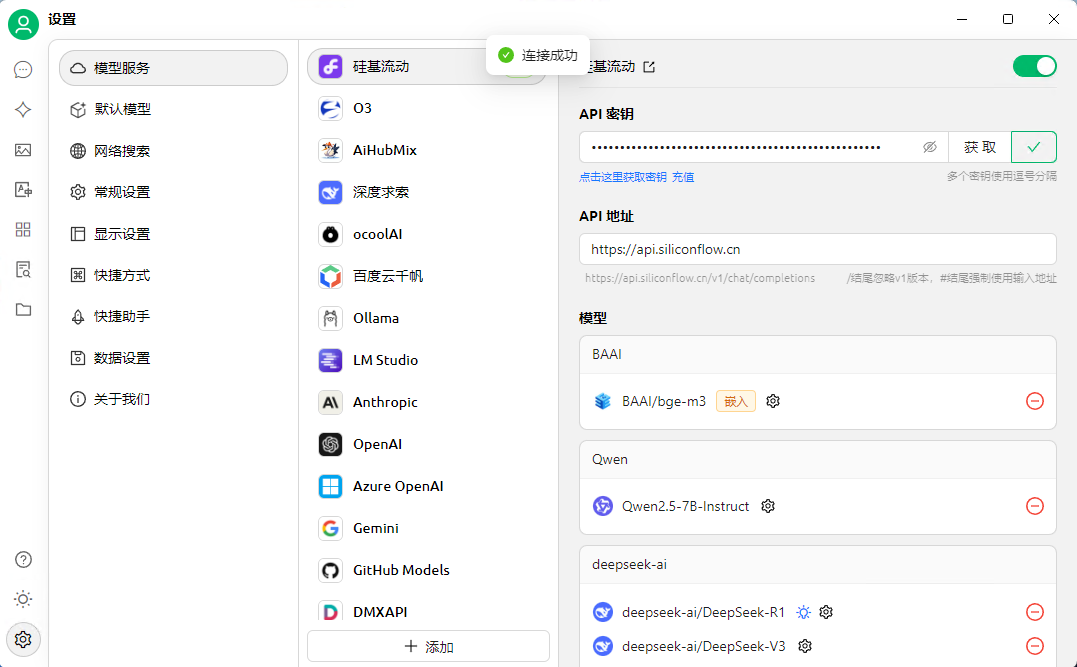

添加完成后上划到顶部,点击 检查 按钮,然后选择刚添加的模型,最后点击确定。测试弹窗为 “连接成功” 时,表示模型添加成功。如果是 “连接失败”,请检查网络连接、API 密钥是否复制正确。

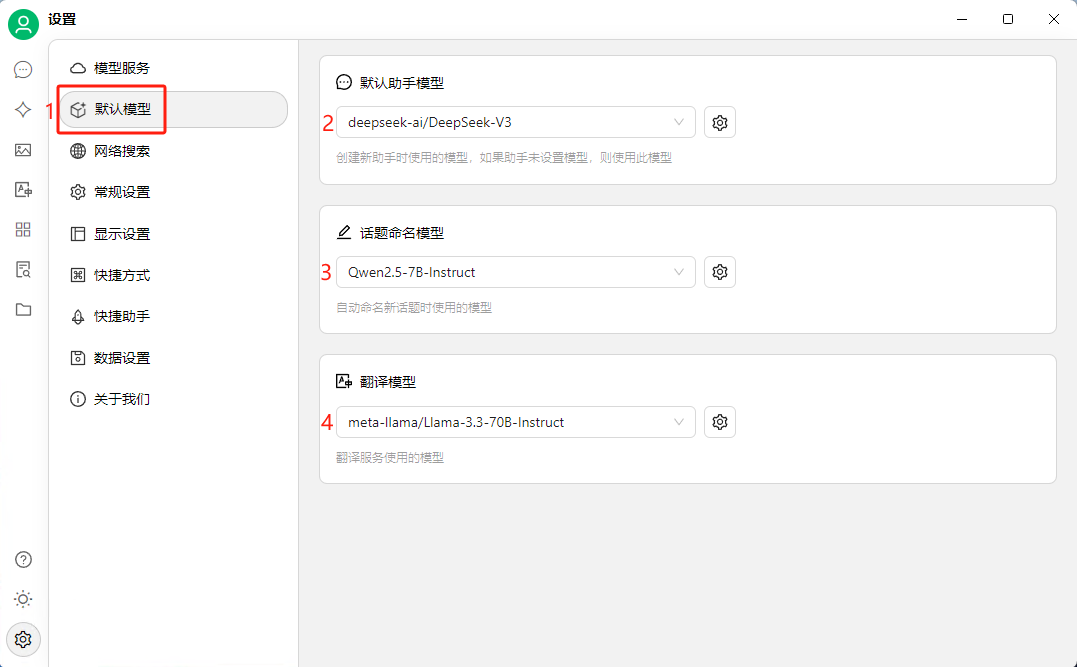

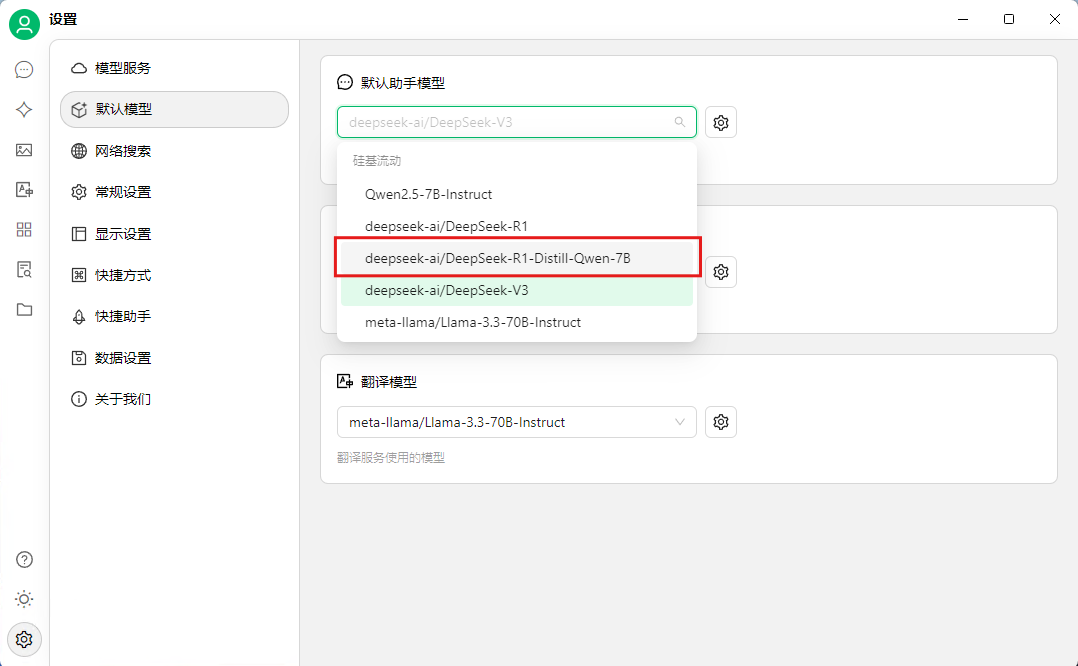

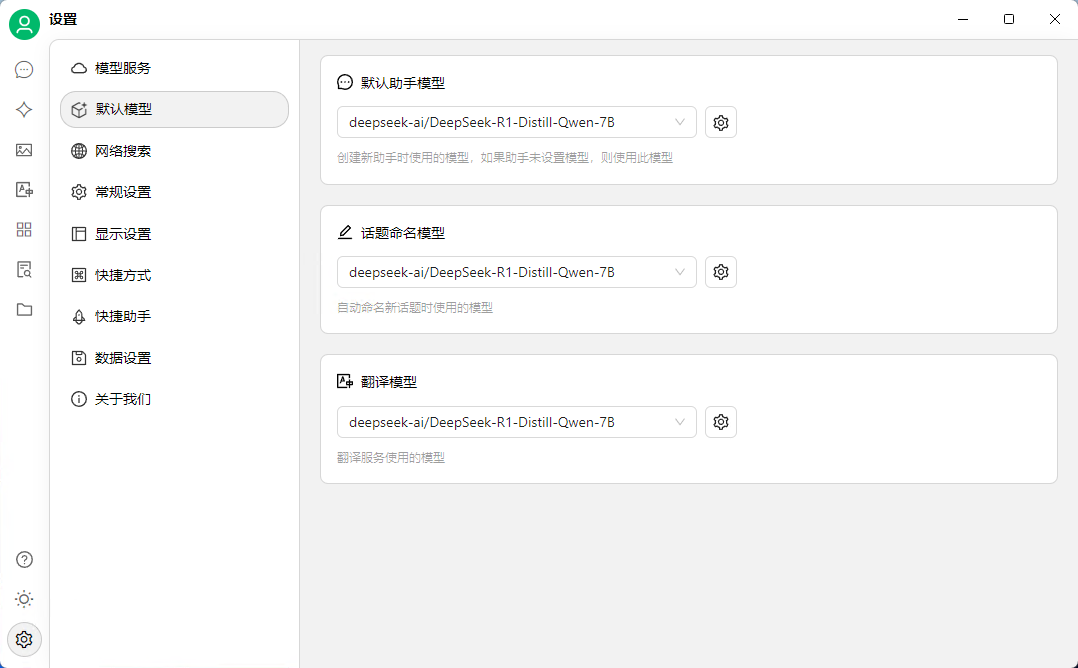

在设置页面点击 默认模型 选项,之后把 2、3、4 依次改成 deepseek-ai/DeepSeek-R1-Distill-Qwen-7B 。

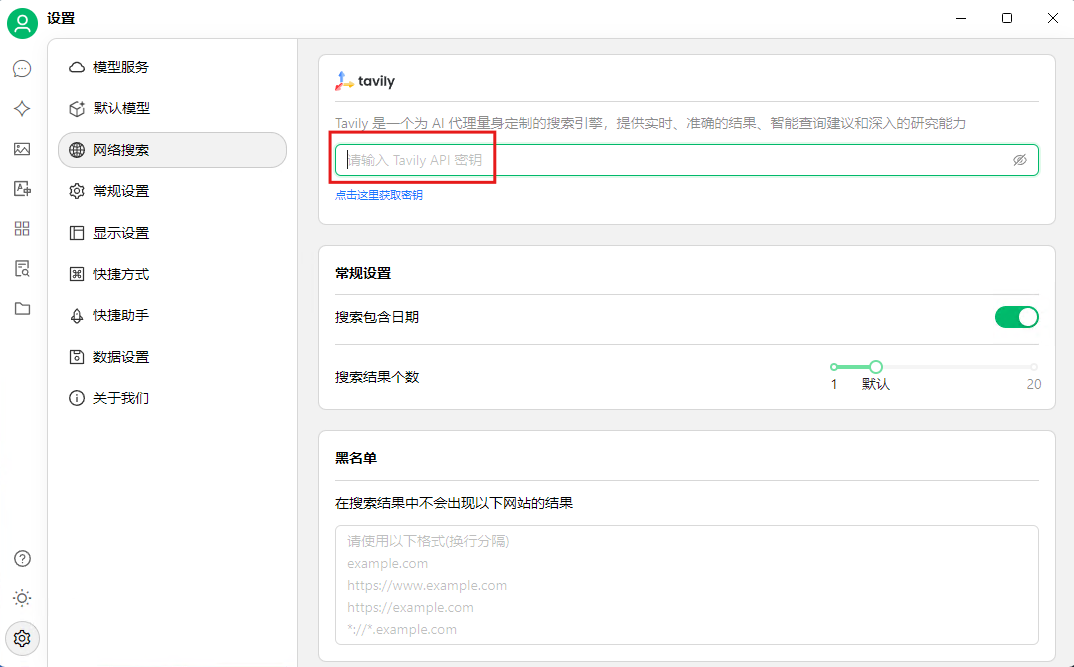

使 AI 具备网络搜索功能(可选)

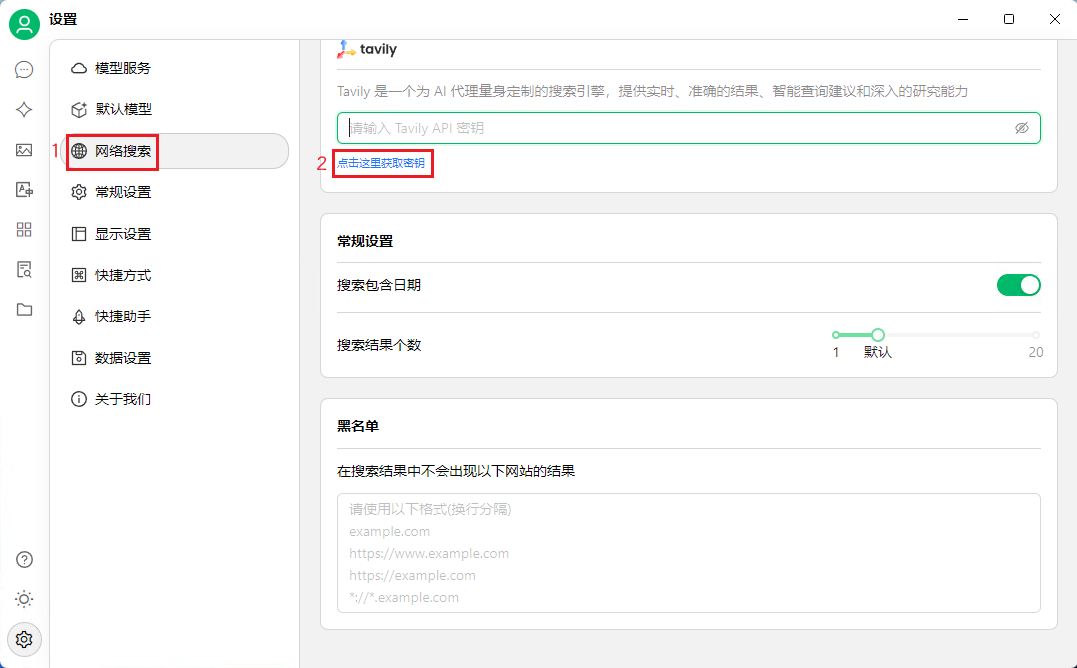

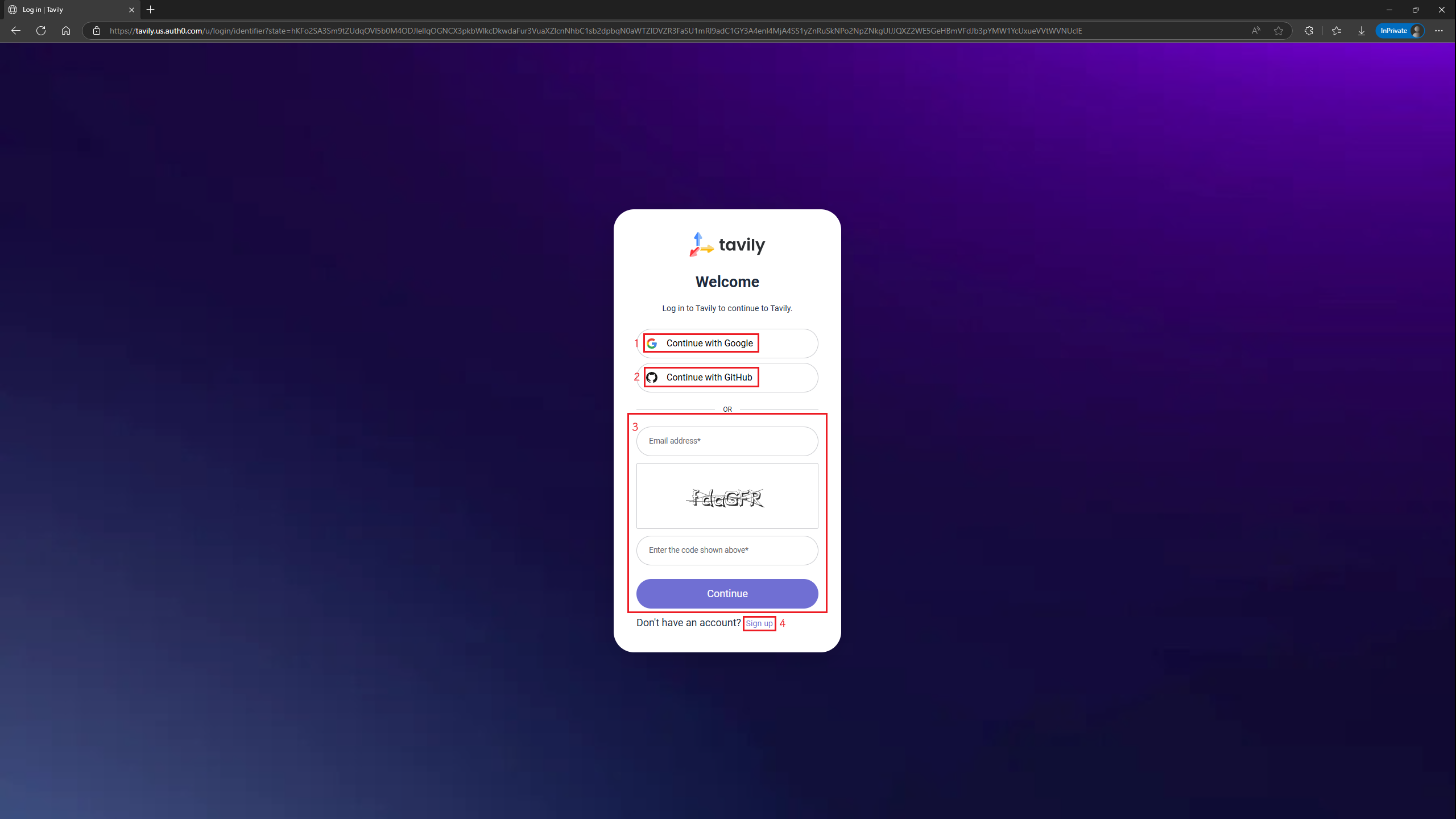

点击设置页面的 网络搜索(1)选项,然后点击 点击这里获取密钥选项(2)或者点击这里,有 Google 或 Github 账号登录点击(1)或(2)登录,之前用过邮箱注册过的点击(3)登录,否则点击(4)注册(建议使用 Google 或 Github 账号直接登录)。

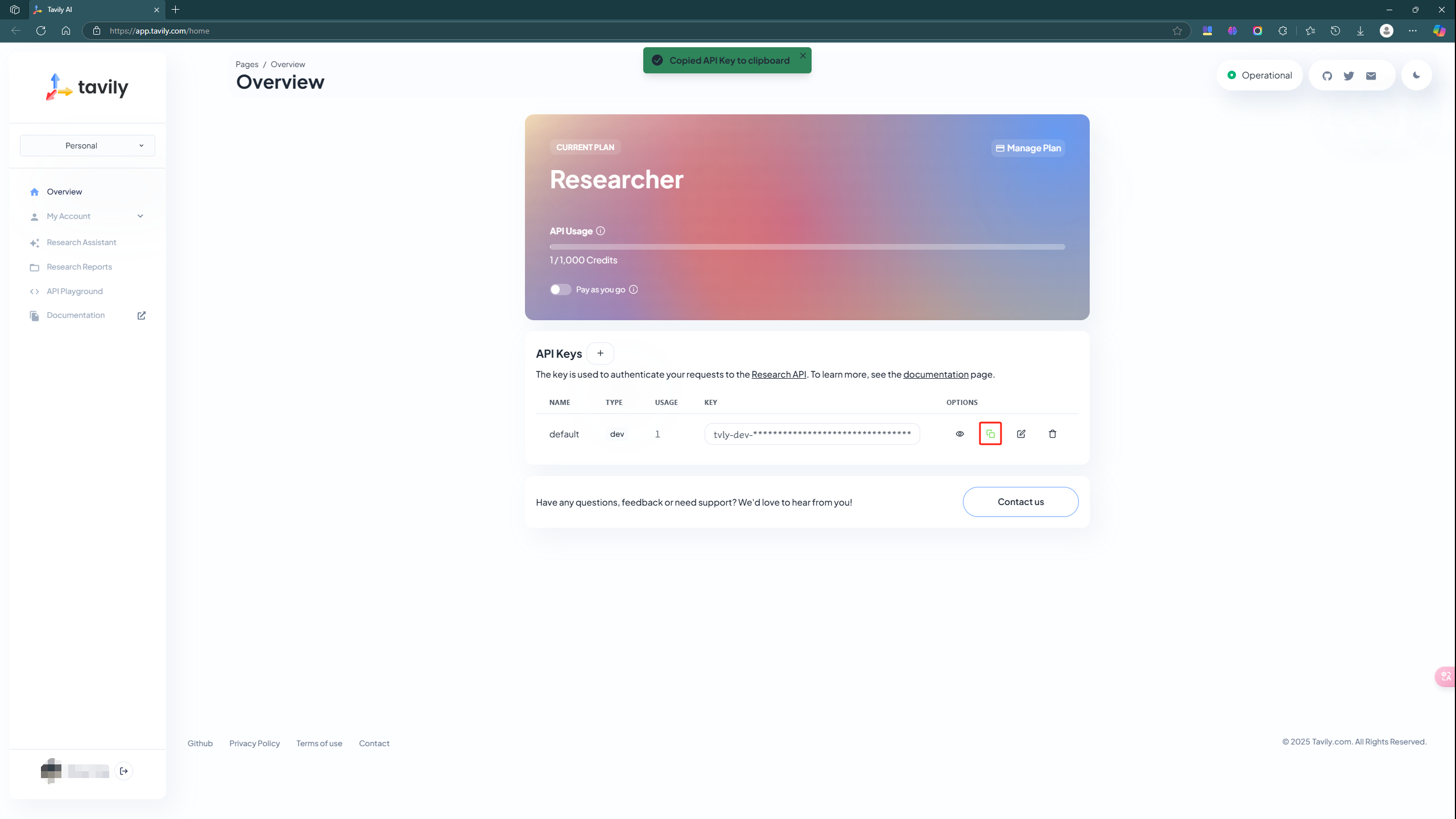

点击复制按钮来复制 KEY,再把 KEY 粘贴到 Cherry Studio 里面。

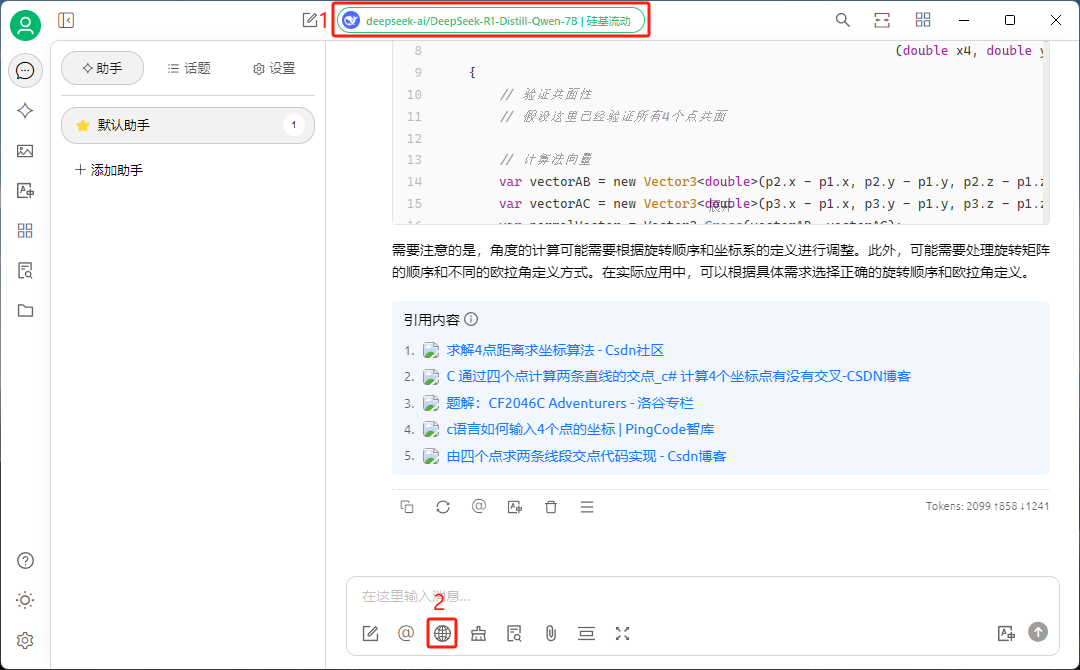

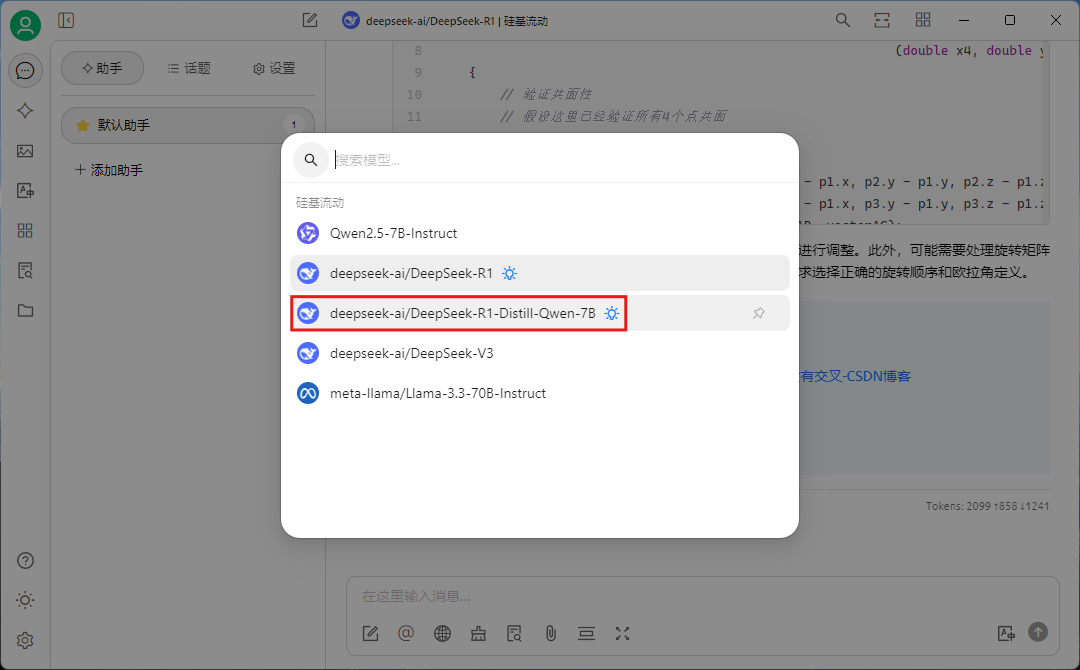

选择 AI 模型

点击(1)处,选择 deepseek-ai/DeepSeek-R1-Distill-Qwen-7B 模型。如果设置了网络搜索功能,则可以点击(2)开启网络搜索功能。

Android(安卓)平台

Chatbox 安装

点击此处下载 APK 安装包或访问官网下载。之后点击下载好的 APK 来安装软件。

参数配置

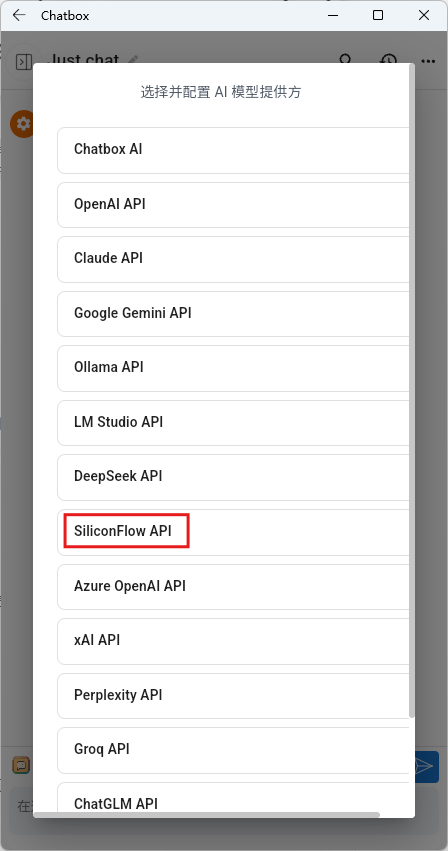

进入软件后会有一个弹窗,选择 使用自己的 API Key 或本地模型 。

在新弹窗选择 SiliconFlow API 。

把硅基流动的密钥粘贴到如下的框中。

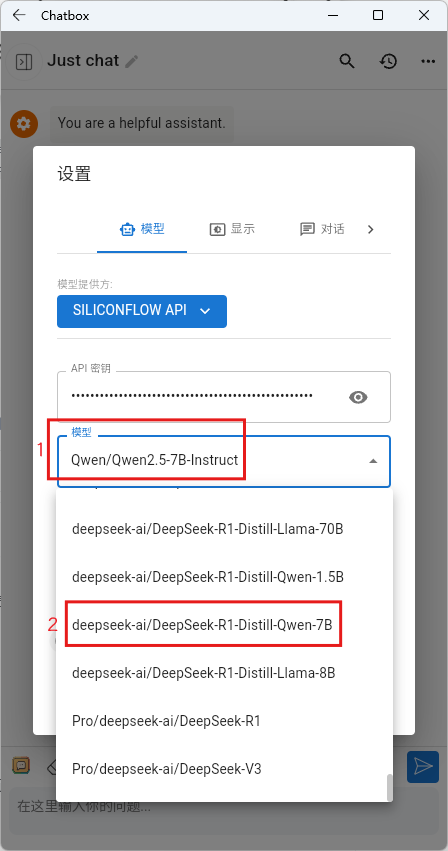

之后点击下拉菜单栏(1),在选项里下划找到 deepseek-ai/DeepSeek-R1-Distill-Qwen-7B(2)模型,然后点击 保存 即可。

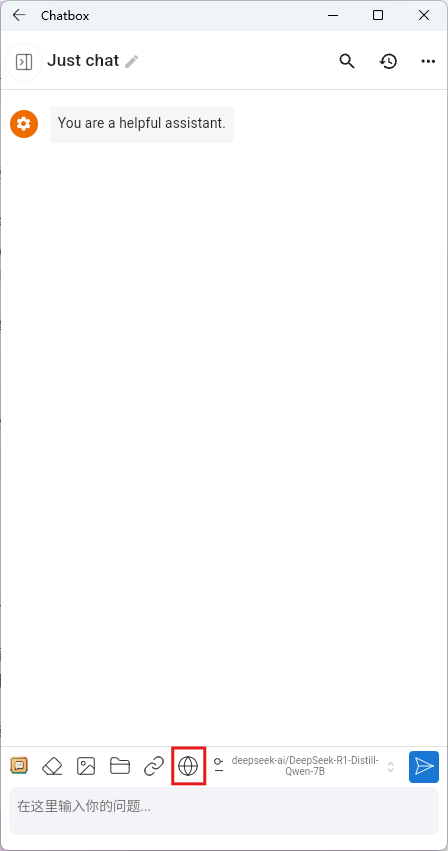

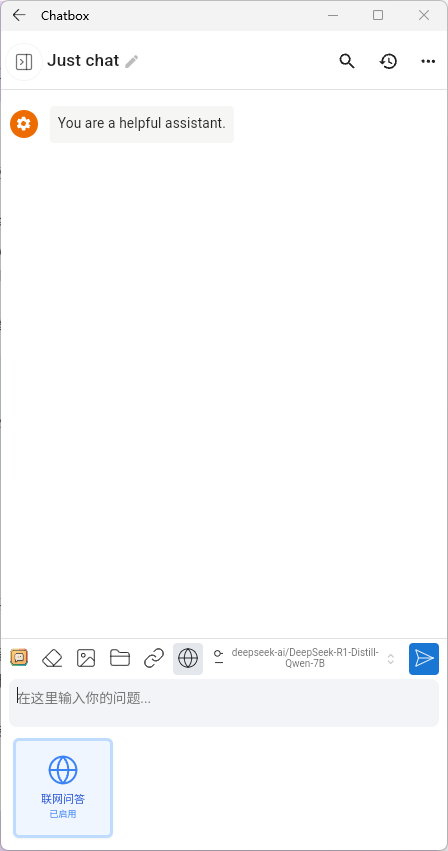

点击如下所示按钮即可开启模型联网功能。

使用本地大模型

本地大模型适合本地电脑性能高,需要定制专用的人。

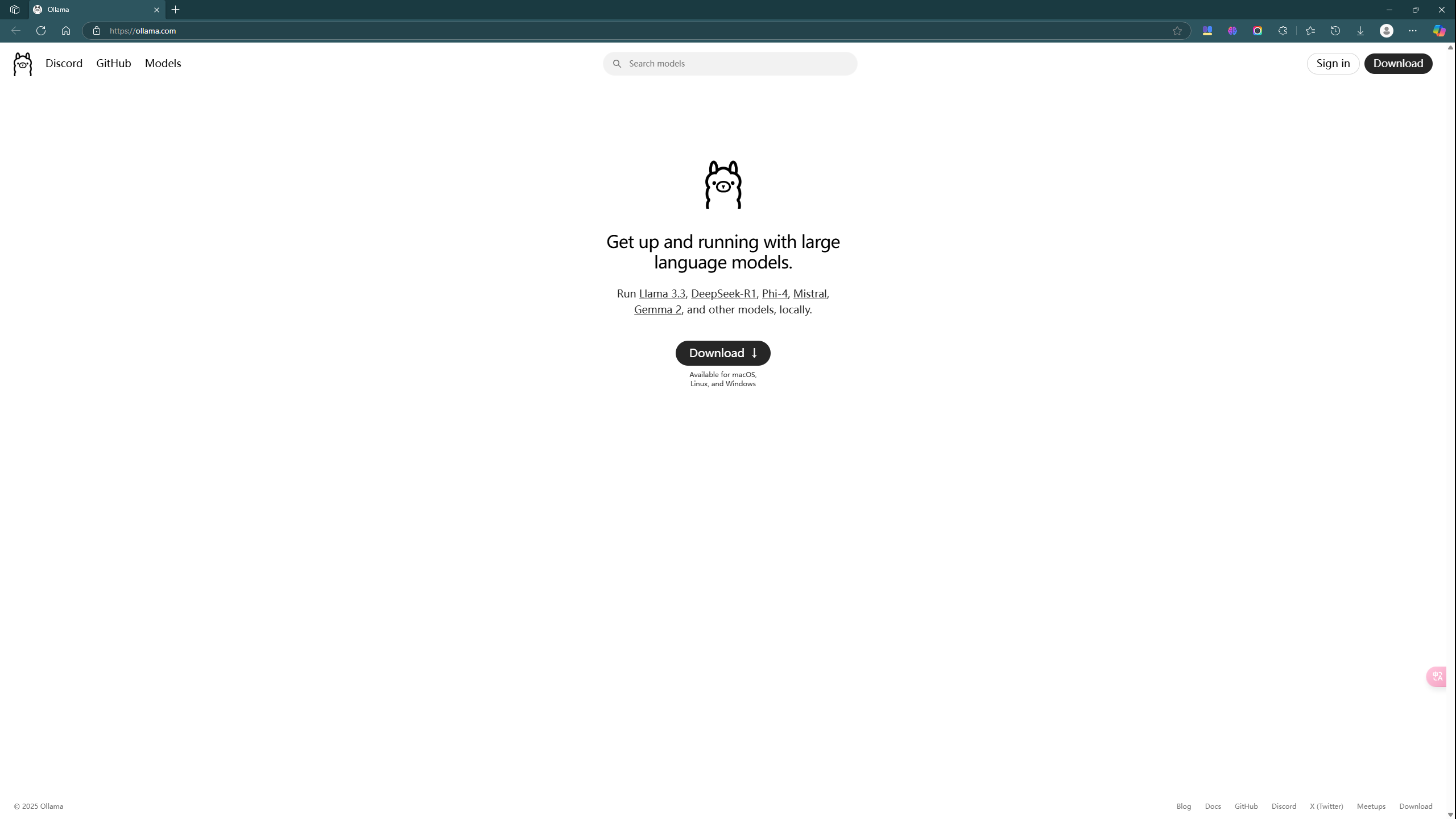

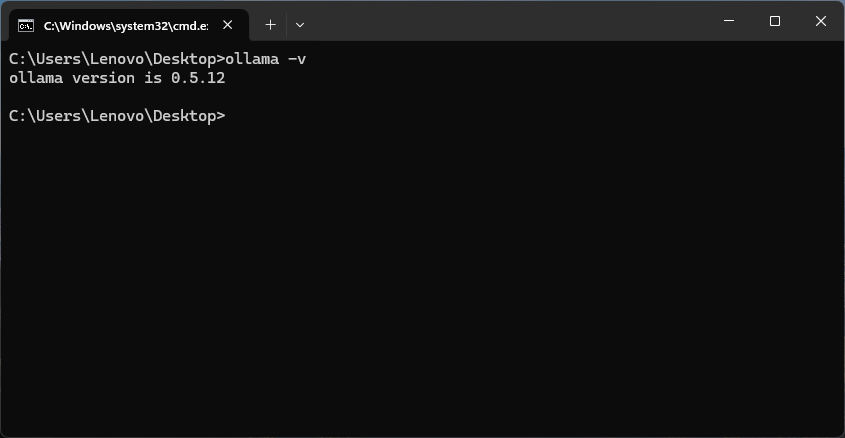

安装 Ollama

访问官网下载安装

安装完成后在 CMD 中输入 ollama -v 验证安装是否成功

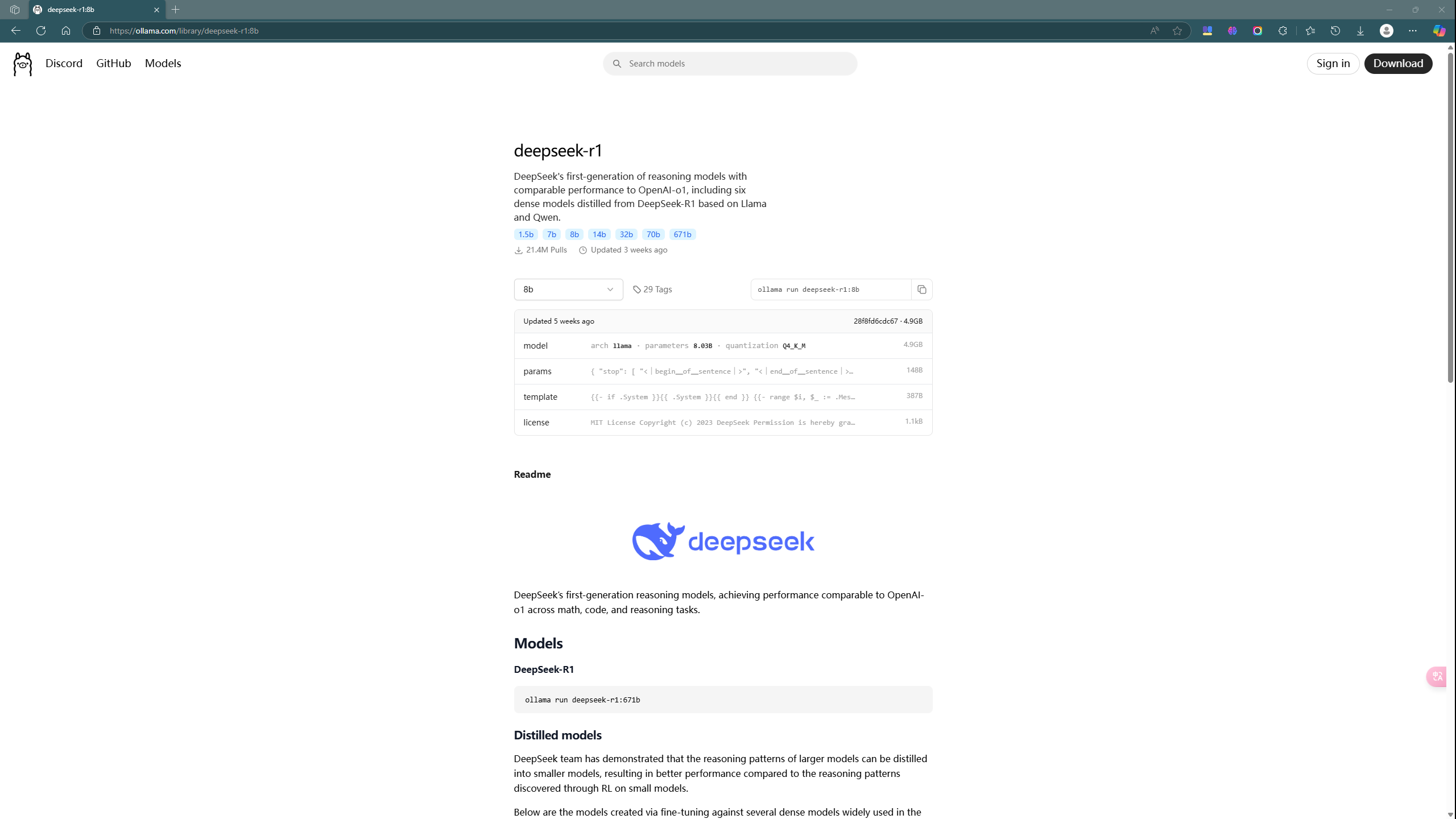

拉取模型

根据个人电脑配置选择模型

| 模型版本 | 参数量 | 显存需求(FP16) | 推荐 GPU(单卡) | 多卡支持 | 量化支持 | 适用场景 |

|---|---|---|---|---|---|---|

| DeepSeek-R1-1.5B | 15亿 | 3GB | GTX 1650(4GB显存) | 无需 | 支持 | 低资源设备部署(树莓派、旧款笔记本)、实时文本生成、嵌入式系统 |

| DeepSeek-R1-7B | 70亿 | 14GB | RTX 3070/4060(8GB显存) | 可选 | 支持 | 中等复杂度任务(文本摘要、翻译)、轻量级多轮对话系统 |

| DeepSeek-R1-8B | 80亿 | 16GB | RTX 4070(12GB显存) | 可选 | 支持 | 需更高精度的轻量级任务(代码生成、逻辑推理) |

| DeepSeek-R1-14B | 140亿 | 32GB | RTX 4090/A5000(16GB显存) | 推荐 | 支持 | 企业级复杂任务(合同分析、报告生成)、长文本理解与生成 |

| DeepSeek-R1-32B | 320亿 | 64GB | A100 40GB(24GB显存) | 推荐 | 支持 | 高精度专业领域任务(医疗/法律咨询)、多模态任务预处理 |

| DeepSeek-R1-70B | 700亿 | 140GB | 2x A100 80GB/4x RTX 4090(多卡并行) | 必需 | 支持 | 科研机构/大型企业(金融预测、大规模数据分析)、高复杂度生成任务 |

| DeepSeek-671B | 6710亿 | 512GB+(单卡显存需求极高,通常需要多节点分布式训练) | 8x A100/H100(服务器集群) | 必需 | 支持 | 国家级/超大规模 AI 研究(气候建模、基因组分析)、通用人工智能(AGI)探索 |

更多版本可以查看这里 。

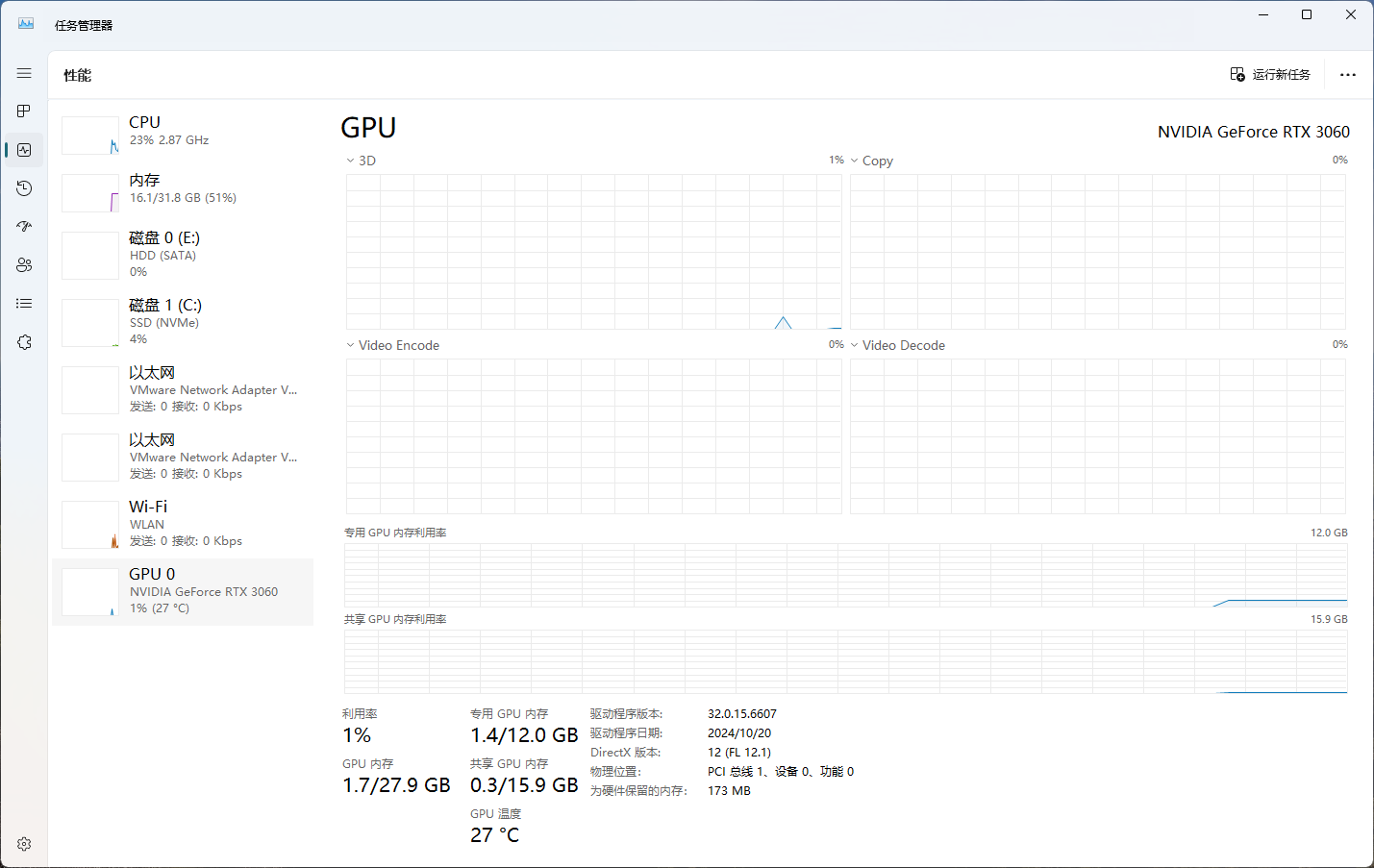

我的电脑配置是

| System | Windows 11 专业版 |

|---|---|

| CPU | 12th Gen Intel® Core™ i7-12700F |

| RAM | 32G |

| GPU | NVIDIA® GeForce RTX™ 3060 12G |

| Disk | SAMSUNG MZVL4512HBLU-00BL7 512G |

所以我选择的是 DeepSeek-R1-8B。

命令行输入 ollama run deepseek-r1:8b 拉取 DeepSeek 模型。几分钟后安装完成就可以在控制台进行对话了。

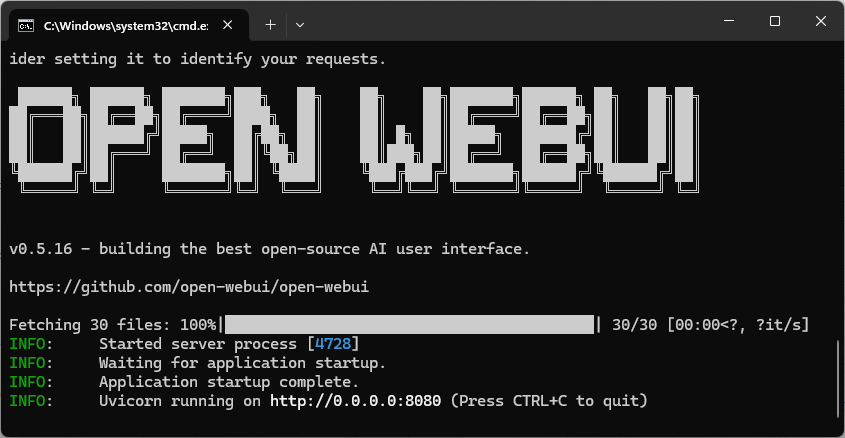

配置交互页面(可选)

使用命令提示符与 DeepSeek 对话并不友好,为了更好的体验,我们可以安装 WebUI 。

命令行输入 pip install open-webui 即可安装。但需注意,Python 版本需要 3.11 及以上。

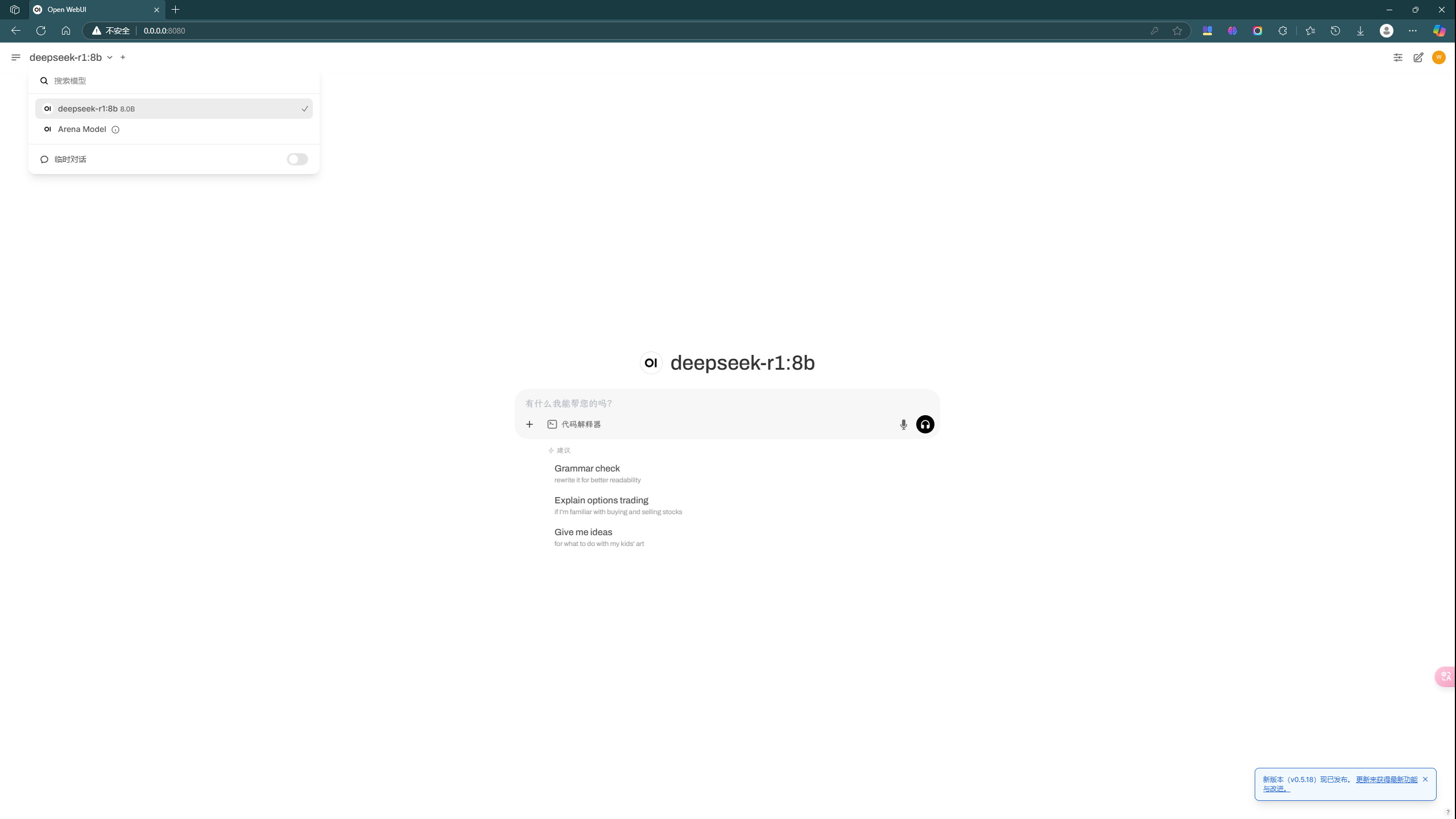

完成后,输入 open-webui serve 即可看到如下界面。

再打开 http://localhost:8080/ 选取模型后就可以使用了。